Gestión de procesos en sistemas operativos: Análisis esencial

Un elemento clave en el funcionamiento eficaz de los sistemas operativos contemporáneos es la gestión procesos. En esencia, un proceso representa un programa en ejecución que requiere recursos del sistema para cumplir su función. Los sistemas operativos actuales deben administrar simultáneamente cientos o incluso miles de procesos, asignando eficientemente el tiempo de CPU, memoria y otros recursos críticos.

Tabla de contenidos

- Gestión de procesos en sistemas operativos

- Componentes esenciales del control de procesos

- Ciclo de vida de un proceso: Del nacimiento a la terminación

- Algoritmos de planificación y su impacto en el rendimiento

- Concurrencia y paralelismo: Desafíos y soluciones

- Comunicación entre procesos: Mecanismos esenciales

- Gestión de memoria en relación con los procesos

- Problemas clásicos en gestión de procesos

- Tendencias actuales: Virtualización y contenedores

- Monitorización y optimización del rendimiento

- Preguntas frecuentes sobre gestión de procesos en sistemas operativos

- ¿Cuál es la diferencia entre un proceso y un hilo?

- ¿Cómo afecta el número de núcleos de CPU a la gestión de procesos?

- ¿Qué impacto tiene la virtualización en la gestión de procesos?

- ¿Por qué los sistemas operativos modernos utilizan planificación preemptiva?

- ¿Cuándo es recomendable ajustar las prioridades de los procesos?

- ¿Qué ventajas ofrece la gestión de procesos en microkernel frente a núcleo monolítico?

- ¿Cómo gestionan los sistemas operativos los procesos zombies?

- Conclusión sobre la gestión de procesos en sistemas operativos

- Referencias

Gestión de procesos en sistemas operativos

Esta compleja tarea de orquestación determina en gran medida el rendimiento global del sistema. Un sistema operativo con una gestión de procesos deficiente puede experimentar bloqueos frecuentes, tiempos de respuesta prolongados y aprovechamiento ineficiente del hardware disponible. Por el contrario, una implementación óptima de los algoritmos de gestión de procesos garantiza la fluidez y estabilidad que los usuarios esperan.

La evolución de esta disciplina ha sido notable desde los primeros sistemas operativos que apenas podían ejecutar un único proceso hasta los sofisticados sistemas multitarea y multiprocesador actuales. Esta transformación refleja tanto los avances en hardware como la creciente complejidad de las aplicaciones modernas, que demandan paradigmas de gestión cada vez más refinados.

Componentes esenciales del control de procesos

El núcleo de la gestión de procesos en sistemas operativos comprende diversos componentes interrelacionados que trabajan en conjunto para garantizar la ejecución eficiente de las aplicaciones:

- Planificador de procesos: Determina qué proceso debe ejecutarse en cada momento.

- Administrador de memoria: Asigna y libera espacio en memoria para los procesos.

- Controlador de entrada/salida: Gestiona las operaciones de E/S requeridas por los procesos.

- Sistema de archivos: Proporciona acceso organizado a los datos almacenados.

- Gestor de interrupciones: Maneja eventos externos e internos que requieren atención inmediata.

Estos componentes no operan de forma aislada, sino que mantienen una comunicación constante y coordinada. Por ejemplo, cuando un proceso requiere realizar una operación de entrada/salida, el planificador debe suspenderlo temporalmente mientras el controlador de E/S completa la tarea solicitada. Esta sincronización requiere mecanismos sofisticados de señalización y control.

Además, los sistemas modernos implementan capas de abstracción que simplifican la interacción entre estos componentes, facilitando el desarrollo tanto del propio sistema operativo como de las aplicaciones que se ejecutan sobre él.

Ciclo de vida de un proceso: Del nacimiento a la terminación

Todo proceso en un sistema operativo atraviesa diversas etapas desde su creación hasta su finalización. Este ciclo vital comprende estados bien definidos que reflejan la relación del proceso con los recursos del sistema:

- Creación: El proceso se inicia, se asignan sus estructuras de datos básicas y se incorpora a la cola de procesos listos.

- Listo: El proceso espera a que el planificador le asigne tiempo de CPU.

- Ejecución: El proceso utiliza activamente la CPU para realizar sus operaciones.

- Bloqueado: El proceso aguarda la finalización de algún evento, como una operación de E/S.

- Terminado: El proceso ha completado su ejecución y sus recursos son liberados.

La transición entre estos estados constituye un aspecto crítico de la gestión de procesos en sistemas operativos. Por ejemplo, un proceso en ejecución puede bloquearse voluntariamente al solicitar una operación de entrada/salida, o puede ser interrumpido forzosamente por el planificador para ceder el procesador a otro proceso de mayor prioridad.

Los sistemas operativos modernos implementan estructuras de datos optimizadas, como bloques de control de procesos (PCB), que almacenan toda la información necesaria para rastrear y gestionar cada proceso a lo largo de su ciclo de vida. Estas estructuras incluyen identificadores únicos, prioridades, contadores de programa, registros y otros datos esenciales para mantener el contexto de ejecución.

Algoritmos de planificación y su impacto en el rendimiento

La elección del algoritmo de planificación determina cómo se distribuye el tiempo de procesador entre los múltiples procesos activos. Esta decisión afecta directamente parámetros críticos como el tiempo de respuesta, el aprovechamiento de CPU y la equidad en la asignación de recursos.

Entre los algoritmos más relevantes en la gestión de procesos en sistemas operativos destacan:

| Algoritmo | Funcionamiento | Ventajas | Desventajas |

|---|---|---|---|

| FCFS (First-Come, First-Served) | Ejecuta los procesos en orden de llegada | Simple de implementar, evita inanición | Tiempos de espera prolongados para procesos cortos |

| SJF (Shortest Job First) | Prioriza procesos con menor tiempo de ejecución | Minimiza tiempo medio de espera | Puede causar inanición en procesos largos |

| Round Robin | Asigna quantum de tiempo fijos y circulares | Distribución equitativa, adecuado para entornos interactivos | Rendimiento depende de la elección del quantum |

| Planificación por prioridades | Selecciona según nivel de importancia asignado | Flexible para diferentes necesidades | Riesgo de inanición de procesos con baja prioridad |

| Planificación multinivel | Combina varios algoritmos en diferentes colas | Optimiza diferentes tipos de procesos | Complejidad de implementación y ajuste |

La selección del algoritmo óptimo depende del contexto específico de uso del sistema. Por ejemplo, los servidores de bases de datos pueden beneficiarse de planificadores que priorizan operaciones de entrada/salida, mientras que sistemas interactivos como equipos de escritorio requieren algoritmos que favorezcan tiempos de respuesta cortos.

Los sistemas operativos modernos como Linux implementan planificadores híbridos sofisticados que adaptan dinámicamente su comportamiento según la carga del sistema y las características de los procesos en ejecución.

Concurrencia y paralelismo: Desafíos y soluciones

La capacidad de ejecutar múltiples procesos simultáneamente representa tanto una oportunidad como un desafío para la gestión de procesos en sistemas operativos. Esta simultaneidad puede materializarse mediante dos aproximaciones complementarias:

- Concurrencia: Permite alternar rápidamente entre procesos, creando la ilusión de ejecución simultánea aunque físicamente se utilice un único procesador.

- Paralelismo: Implica la ejecución genuinamente simultánea de procesos en múltiples núcleos o procesadores.

Ambos enfoques presentan complejidades específicas. La concurrencia requiere mecanismos eficientes de cambio de contexto, mientras que el paralelismo introduce desafíos adicionales como la coherencia de caché y la distribución equilibrada de carga entre núcleos.

Los sistemas operativos modernos implementan soluciones sofisticadas como:

- Mutex y semáforos: Mecanismos de sincronización que previenen condiciones de carrera.

- Monitores: Abstracciones que facilitan la exclusión mutua y la sincronización.

- Mensajes y canales: Permiten la comunicación ordenada entre procesos.

- Memoria transaccional: Facilita operaciones atómicas complejas sin bloqueos.

El adecuado equilibrio entre concurrencia y paralelismo resulta crucial para maximizar tanto el rendimiento como la eficiencia energética, especialmente en la era actual donde los procesadores multinúcleo son omnipresentes incluso en dispositivos móviles.

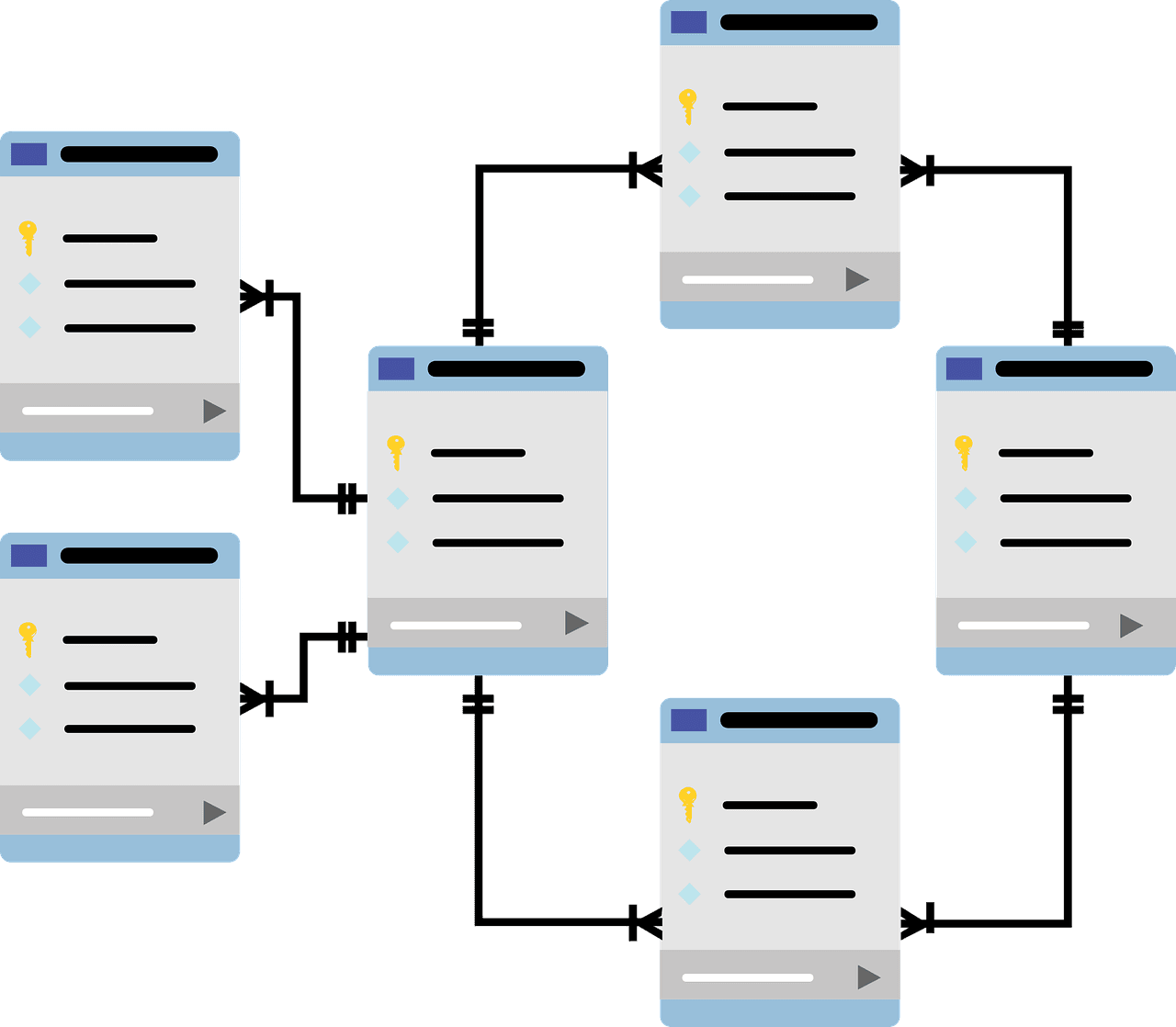

Comunicación entre procesos: Mecanismos esenciales

Los procesos en un sistema operativo rara vez operan de forma aislada. La colaboración entre ellos requiere mecanismos especializados de comunicación y sincronización conocidos como IPC (Inter-Process Communication). Estos mecanismos son fundamentales en la gestión de procesos en sistemas operativos modernos.

Los principales métodos de comunicación incluyen:

- Tuberías (pipes): Canales unidireccionales que permiten la transferencia secuencial de datos.

- Colas de mensajes: Estructuras que almacenan y entregan mensajes discretos entre procesos.

- Memoria compartida: Regiones de memoria accesibles por múltiples procesos, ofreciendo comunicación de alta velocidad.

- Sockets: Interfaces de comunicación que permiten el intercambio de datos incluso entre máquinas distintas.

- Señales: Notificaciones asíncronas que informan a los procesos sobre eventos específicos.

La elección del mecanismo adecuado depende de factores como el volumen de datos a transferir, la frecuencia de comunicación y los requisitos de sincronización. Por ejemplo, la memoria compartida ofrece el mayor rendimiento para transferencias masivas de datos, mientras que las señales resultan ideales para notificaciones puntuales.

Los sistemas operativos modernos como UNIX y sus derivados han perfeccionado estos mecanismos a lo largo de décadas, estableciendo APIs estandarizadas que facilitan el desarrollo de aplicaciones complejas y distribuidas.

Gestión de memoria en relación con los procesos

La asignación y administración de memoria constituye un aspecto crítico en la gestión de procesos en sistemas operativos. Cada proceso requiere espacio para su código ejecutable, datos y pila, recursos que deben ser gestionados con precisión para evitar conflictos y desperdicios.

Las técnicas modernas de gestión de memoria incluyen:

- Paginación: Divide la memoria física y lógica en bloques de tamaño fijo llamados páginas, facilitando la asignación no contigua.

- Segmentación: Organiza la memoria en segmentos lógicos de tamaño variable según la estructura del programa.

- Memoria virtual: Crea la ilusión de una memoria más amplia mediante el uso coordinado de almacenamiento secundario.

- Swapping: Permite transferir temporalmente procesos completos entre memoria principal y secundaria.

Estas técnicas trabajan en estrecha colaboración con el planificador de procesos. Por ejemplo, cuando un proceso es seleccionado para ejecución, el sistema debe asegurar que sus páginas relevantes estén cargadas en memoria física, iniciando operaciones de paginación si es necesario.

Los sistemas operativos contemporáneos implementan algoritmos sofisticados como LRU (Least Recently Used) o algoritmos adaptativos para optimizar estos mecanismos según patrones de acceso observados, minimizando así la sobrecarga asociada con fallos de página y operaciones de entrada/salida.

Problemas clásicos en gestión de procesos

La gestión de procesos en sistemas operativos enfrenta varios desafíos recurrentes que han motivado el desarrollo de soluciones algorítmicas clásicas en ciencias de la computación:

- Deadlock (interbloqueo): Situación donde dos o más procesos se bloquean indefinidamente esperando recursos que posee el otro. Las estrategias para abordarlo incluyen prevención, evitación, detección y recuperación.

- Inanición (starvation): Ocurre cuando un proceso nunca recibe los recursos necesarios para avanzar. Se mitiga mediante algoritmos de planificación con envejecimiento.

- Sobrecarga de contexto: El costo de cambiar entre procesos puede degradar el rendimiento si ocurre con excesiva frecuencia. Se optimiza mediante agrupación de operaciones y reducción de interrupciones.

- Fragmentación de memoria: Tanto interna como externa, dificulta la asignación eficiente de memoria a los procesos. Se combate con técnicas como compactación y paginación.

Estos problemas adquieren mayor complejidad en sistemas distribuidos y en la nube, donde la coordinación entre múltiples nodos añade dimensiones adicionales a la gestión de procesos. Las soluciones modernas frecuentemente combinan enfoques teóricos clásicos con heurísticas adaptativas y aprendizaje automático para optimizar decisiones en tiempo real.

Tendencias actuales: Virtualización y contenedores

Las tecnologías de virtualización y contenedorización han revolucionado la gestión de procesos en sistemas operativos al introducir nuevas capas de abstracción que modifican fundamentalmente la relación entre procesos y hardware:

- Máquinas virtuales: Permiten ejecutar múltiples sistemas operativos completos sobre un único hardware físico, cada uno con su propia gestión de procesos aislada.

- Contenedores: Ofrecen entornos de ejecución ligeros que comparten el kernel del sistema anfitrión pero mantienen aislamiento a nivel de procesos, sistemas de archivos y redes.

- Orquestadores: Herramientas como Kubernetes que automatizan la distribución, escalado y gestión de aplicaciones contenerizadas.

Estas tecnologías han permitido avances significativos en la eficiencia de recursos, portabilidad de aplicaciones y resistencia a fallos. Por ejemplo, los microservicios modernos aprovechan contenedores para desplegar componentes individuales de aplicaciones complejas, facilitando actualizaciones graduales y escalado preciso según demanda.

Los sistemas operativos contemporáneos han evolucionado para optimizar estas cargas de trabajo, incorporando capacidades nativas para gestionar eficientemente la virtualización anidada y minimizar la sobrecarga asociada a estas capas adicionales de abstracción.

Monitorización y optimización del rendimiento

La supervisión continua de los procesos en ejecución permite identificar cuellos de botella y optimizar el rendimiento global del sistema. Las herramientas y técnicas modernas para monitorizar la gestión de procesos en sistemas operativos incluyen:

- Perfiladores de sistema: Registran métricas detalladas sobre utilización de CPU, memoria y E/S por proceso.

- Trazadores de eventos: Capturan secuencias de llamadas al sistema y cambios de contexto para análisis posterior.

- Visualizadores de rendimiento: Transforman datos complejos en representaciones gráficas intuitivas.

- Análisis predictivo: Utilizan aprendizaje automático para anticipar problemas potenciales antes de que impacten a los usuarios.

Esta monitorización proporciona datos valiosos tanto para administradores de sistemas como para desarrolladores. Por ejemplo, detectar un proceso con consumo anómalo de memoria puede revelar una fuga que requiere corrección en el código fuente.

Los sistemas operativos modernos integran capacidades avanzadas de autodiagnóstico, permitiendo ajustes automáticos de parámetros como tamaños de quantum, prioridades dinámicas o políticas de paginación en función de la carga observada y objetivos específicos de rendimiento.

Preguntas frecuentes sobre gestión de procesos en sistemas operativos

¿Cuál es la diferencia entre un proceso y un hilo?

Un proceso representa un programa en ejecución con su propio espacio de memoria aislado, mientras que los hilos (threads) son unidades de ejecución que comparten el mismo espacio de memoria dentro de un proceso. Los hilos permiten paralelismo dentro de una aplicación con menor sobrecarga que múltiples procesos.

¿Cómo afecta el número de núcleos de CPU a la gestión de procesos?

Mayor número de núcleos permite ejecutar más procesos en paralelo genuino, reduciendo la necesidad de cambios de contexto. Sin embargo, esto también requiere algoritmos de planificación más sofisticados para distribuir eficientemente la carga y mantener los núcleos equilibrados.

¿Qué impacto tiene la virtualización en la gestión de procesos?

La virtualización añade una capa adicional de abstracción, donde el hipervisor debe gestionar tanto los procesos del sistema anfitrión como los sistemas operativos invitados. Esto introduce complejidades como la planificación anidada y el manejo de interrupciones virtualizadas.

¿Por qué los sistemas operativos modernos utilizan planificación preemptiva?

La planificación preemptiva permite al sistema operativo interrumpir procesos en ejecución, garantizando que ninguna aplicación monopolice los recursos. Esto mejora la capacidad de respuesta, especialmente en sistemas interactivos, y previene que programas mal diseñados bloqueen el sistema.

¿Cuándo es recomendable ajustar las prioridades de los procesos?

Es aconsejable modificar prioridades cuando aplicaciones críticas requieren respuesta inmediata (como software en tiempo real) o cuando procesos de baja importancia consumen recursos excesivos. Sin embargo, estas modificaciones deben realizarse con cautela para evitar problemas de inanición.

¿Qué ventajas ofrece la gestión de procesos en microkernel frente a núcleo monolítico?

Los microkernels mantienen solo funcionalidades esenciales en el espacio del núcleo, ejecutando servicios como gestión de archivos o redes como procesos de usuario. Esto mejora la estabilidad (un fallo en un servicio no compromete todo el sistema) y modularidad, aunque puede introducir cierta sobrecarga de rendimiento.

¿Cómo gestionan los sistemas operativos los procesos zombies?

Los procesos zombies ocurren cuando un proceso hijo termina pero su padre no recoge el código de salida. Ocupan entradas en la tabla de procesos aunque no consumen otros recursos. Los sistemas modernos implementan mecanismos como señales SIGCHLD y adopción por el proceso init para minimizar su impacto.

Conclusión sobre la gestión de procesos en sistemas operativos

La gestión de procesos en sistemas operativos representa un componente fundamental que determina en gran medida el rendimiento, estabilidad y eficiencia de los sistemas computacionales modernos. Desde la asignación de recursos hasta la comunicación entre procesos, cada aspecto debe optimizarse cuidadosamente para satisfacer las crecientes demandas de aplicaciones y usuarios.

A medida que avanzamos hacia entornos cada vez más distribuidos y heterogéneos, con procesadores multinúcleo, sistemas en la nube y dispositivos edge, los paradigmas de gestión de procesos continúan evolucionando. La virtualización, contenedorización y orquestación representan las tendencias actuales que están redefiniendo la relación entre software y hardware.

Los profesionales de TI deben mantener un conocimiento actualizado sobre estos conceptos y tecnologías para diseñar, implementar y mantener sistemas que aprovechen eficientemente los recursos disponibles mientras proporcionan la experiencia fluida que los usuarios esperan. La comprensión profunda de los algoritmos de planificación, mecanismos de sincronización y técnicas de gestión de memoria seguirá siendo una habilidad valiosa en el ecosistema tecnológico en constante evolución.

Referencias

- Silberschatz, A., Galvin, P. B., & Gagne, G. (2018). Operating System Concepts. Wiley.

- Tanenbaum, A. S., & Bos, H. (2014). Modern Operating Systems. Pearson.

- Stallings, W. (2017). Operating Systems: Internals and Design Principles. Pearson.

- Kubernetes Documentation – Conceptos de orquestación de contenedores.

- Linux Kernel Documentation – Documentación oficial sobre implementación de procesos en Linux.