La revolucionaria Arquitectura de Von Neumann

El mundo de la tecnología que conocemos hoy no existiría sin un conjunto de principios fundamentales establecidos hace más de 75 años. Cada vez que encendemos un dispositivo digital—desde el más sofisticado superordenador hasta el modesto smartphone—estamos poniendo en marcha un legado intelectual que revolucionó para siempre nuestra relación con las máquinas. Los cimientos de esta revolución descansan en una estructura conceptual brillante que permitió que las computadoras pasaran de ser meras calculadoras a convertirse en los sistemas versátiles que hoy dan forma a prácticamente todos los aspectos de nuestra vida moderna.

Tabla de contenidos

- Arquitectura de Von Neumann

- Orígenes históricos de la Arquitectura de Von Neumann

- Componentes fundamentales de la Arquitectura de Von Neumann

- El ciclo de instrucción en la Arquitectura de Von Neumann

- Memoria unificada en la Arquitectura de Von Neumann

- Cuello de botella de Von Neumann

- Arquitectura Harvard: la alternativa a Von Neumann

- Evolución y avances de la Arquitectura de Von Neumann

- Impacto en la computación moderna

- El futuro de la Arquitectura de Von Neumann

- Conclusiones

- Referencias externas

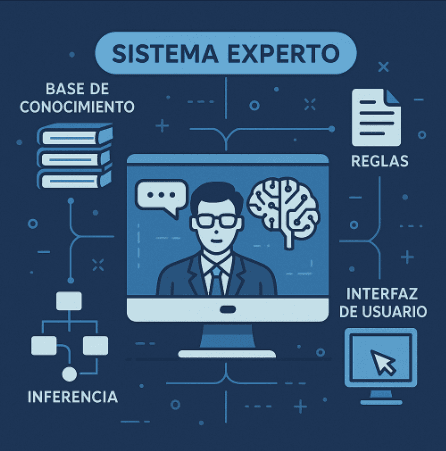

Arquitectura de Von Neumann

La Arquitectura de Von Neumann constituye el paradigma fundamental sobre el cual se han construido prácticamente todas las computadoras modernas. Esta arquitectura, propuesta por el matemático John von Neumann en 1945, establece un diseño donde tanto los datos como las instrucciones se almacenan en la misma memoria, permitiendo que sean procesados por una unidad central. ¿Qué hace que este modelo sea tan significativo? Principalmente, su enfoque unificado permite a las máquinas manipular sus propias instrucciones como si fueran datos, otorgándoles una flexibilidad sin precedentes.

La Arquitectura de Von Neumann se compone esencialmente de cuatro unidades interconectadas:

- Unidad de Procesamiento (CPU): El «cerebro» que ejecuta las instrucciones.

- Unidad de Control: Coordina las operaciones y dirige el flujo de información.

- Memoria: Almacena tanto datos como instrucciones en un mismo espacio.

- Dispositivos de Entrada/Salida: Permiten la comunicación con el mundo exterior.

Estos componentes se comunican entre sí mediante buses de datos, direcciones y control, formando un sistema integrado que puede ejecutar secuencialmente cualquier tipo de programa almacenado. Es precisamente esta capacidad de almacenar programas lo que distingue a la Arquitectura de Von Neumann y lo que ha permitido el desarrollo de sistemas computacionales cada vez más complejos y versátiles.

Orígenes históricos de la Arquitectura de Von Neumann

La concepción de esta arquitectura revolucionaria tiene sus raíces en el turbulento contexto de la Segunda Guerra Mundial. John von Neumann, un brillante matemático húngaro-estadounidense, formalizó este modelo en su histórico documento «First Draft of a Report on the EDVAC» en 1945. ¿Sabía von Neumann que estaba sentando las bases para toda una revolución tecnológica? Probablemente intuía la importancia de su trabajo, pero difícilmente podría haber anticipado el alcance monumental que tendría.

Von Neumann no trabajó en aislamiento. Colaboró estrechamente con J. Presper Eckert y John Mauchly, quienes habían desarrollado el ENIAC (Electronic Numerical Integrator and Computer), considerada la primera computadora electrónica de propósito general. Sin embargo, el ENIAC tenía una limitación fundamental: para reprogramarlo era necesario reconectar físicamente sus componentes, un proceso tedioso y propenso a errores.

La verdadera innovación de von Neumann fue conceptualizar un sistema donde las instrucciones del programa pudieran almacenarse en la misma memoria que los datos, permitiendo que la máquina manipulara sus propias instrucciones. Esta idea aparentemente simple transformó las computadoras de calculadoras especializadas a máquinas verdaderamente programables, capaces de ejecutar cualquier algoritmo que pudiera expresarse en código.

Componentes fundamentales de la Arquitectura de Von Neumann

Para comprender a fondo la Arquitectura de Von Neumann, es crucial examinar detalladamente cada uno de sus componentes esenciales y cómo interactúan entre sí:

Unidad Central de Procesamiento (CPU)

El corazón de la Arquitectura de Von Neumann es la CPU, que a su vez se divide en:

- Unidad Aritmético-Lógica (ALU): Realiza todas las operaciones matemáticas (suma, resta, multiplicación, división) y lógicas (AND, OR, NOT, XOR). ¿Cómo logra ejecutar millones de estas operaciones por segundo? Mediante circuitos electrónicos altamente optimizados que manipulan valores binarios con extraordinaria rapidez.

- Registros: Pequeñas unidades de memoria ultrarrápida dentro de la CPU que almacenan temporalmente datos e instrucciones en procesamiento. Incluyen registros especializados como el contador de programa (PC) que indica la siguiente instrucción a ejecutar, y el registro de instrucción (IR) que contiene la instrucción actual.

- Unidad de Control: Orquesta todas las operaciones, interpretando las instrucciones y enviando señales a los demás componentes para que ejecuten las acciones apropiadas en el momento preciso.

Sistema de Memoria

En la Arquitectura de Von Neumann, la memoria constituye un espacio único que alberga tanto datos como instrucciones. Esta se organiza jerárquicamente:

- Memoria principal (RAM): Proporciona almacenamiento temporal durante la ejecución del programa.

- Memoria caché: Situada entre la CPU y la RAM, almacena datos e instrucciones frecuentemente utilizados para acceso ultrarrápido.

- Memoria secundaria: Dispositivos como discos duros o unidades de estado sólido para almacenamiento permanente.

Sistema de Buses

Los buses funcionan como «autopistas de datos» que conectan los diferentes componentes:

- Bus de datos: Transporta los datos entre la CPU y otros componentes.

- Bus de direcciones: Lleva las direcciones de memoria especificadas por la CPU.

- Bus de control: Transmite señales que coordinan y sincronizan las actividades.

Dispositivos de Entrada/Salida

Estos componentes permiten la comunicación entre el ordenador y el mundo exterior, incluyendo teclados, pantallas, impresoras, micrófonos, altavoces y una amplia variedad de periféricos especializados.

La genialidad de la Arquitectura de Von Neumann radica no solo en estos componentes individuales, sino en cómo se integran en un sistema cohesivo capaz de ejecutar programas almacenados con extraordinaria flexibilidad.

El ciclo de instrucción en la Arquitectura de Von Neumann

El funcionamiento de la Arquitectura de Von Neumann se fundamenta en el ciclo de instrucción, también conocido como ciclo «fetch-decode-execute» (buscar-decodificar-ejecutar). Este proceso secuencial constituye el latido fundamental de cualquier computadora basada en este modelo.

Fase de Búsqueda (Fetch)

Durante esta primera etapa:

- La Unidad de Control obtiene la dirección de la siguiente instrucción del Contador de Programa (PC).

- La instrucción se recupera de la memoria principal y se almacena en el Registro de Instrucción (IR).

- El Contador de Programa se incrementa automáticamente para apuntar a la siguiente instrucción.

Fase de Decodificación (Decode)

Una vez que la instrucción está en el Registro de Instrucción:

- La Unidad de Control analiza y «traduce» la instrucción, identificando la operación específica que debe realizarse.

- Se determinan los operandos necesarios y sus ubicaciones (registros o direcciones de memoria).

Fase de Ejecución (Execute)

En esta fase crucial:

- La Unidad de Control activa los circuitos necesarios para realizar la operación.

- La Unidad Aritmético-Lógica (ALU) ejecuta los cálculos si la instrucción involucra operaciones matemáticas o lógicas.

- Los resultados se almacenan en el destino apropiado (registro o memoria).

Fase de Almacenamiento (Store)

Algunas descripciones del ciclo incluyen una cuarta fase:

- Si la instrucción requiere almacenar un resultado en memoria, se activa el bus de datos.

- El resultado se transfiere a la dirección de memoria especificada.

¿Qué hace que este ciclo sea tan poderoso? Su simplicidad y universalidad. Este mismo proceso básico puede ejecutar cualquier algoritmo, desde una simple suma hasta las más complejas simulaciones de inteligencia artificial. La Arquitectura de Von Neumann ejecuta este ciclo millones o miles de millones de veces por segundo, creando la ilusión de operaciones simultáneas complejas cuando, en realidad, está realizando una secuencia de pasos simples a velocidades asombrosas.

Memoria unificada en la Arquitectura de Von Neumann

Uno de los aspectos más revolucionarios de la Arquitectura de Von Neumann es su concepto de memoria unificada, donde tanto los datos como las instrucciones se almacenan en el mismo espacio de memoria. Esta característica, aparentemente simple, tiene profundas implicaciones en el funcionamiento y capacidades de los sistemas computacionales.

Ventajas del almacenamiento conjunto

La memoria unificada ofrece beneficios significativos:

- Flexibilidad programática: Permite que los programas se modifiquen a sí mismos en tiempo de ejecución, ya que las instrucciones pueden tratarse como datos y viceversa. Esta capacidad de «metaprogramación» es fundamental para compiladores, intérpretes y sistemas operativos modernos.

- Economía de recursos: Al compartir el mismo espacio de memoria, se optimiza el uso de este recurso valioso, especialmente relevante en las primeras computadoras cuando la memoria era extremadamente costosa y limitada.

- Simplificación del diseño: La unificación reduce la complejidad del hardware necesario, al no requerir sistemas de memoria separados con sus propios buses y mecanismos de control.

Implementación y gestión

En la práctica, la memoria unificada se estructura de manera que:

- Cada posición de memoria tiene una dirección única.

- El sistema puede distinguir cuándo está accediendo a datos o a instrucciones según el contexto de la operación.

- Los programas y sus datos se cargan contiguamente en memoria, siguiendo convenciones específicas de organización.

La Arquitectura de Von Neumann implementa esta memoria unificada de forma jerárquica, con distintos niveles de almacenamiento que equilibran velocidad y capacidad:

| Nivel de memoria | Velocidad | Capacidad | Volatilidad |

|---|---|---|---|

| Registros de CPU | Extremadamente rápida | Muy pequeña | Volátil |

| Caché L1, L2, L3 | Muy rápida | Pequeña | Volátil |

| Memoria principal (RAM) | Rápida | Media | Volátil |

| Almacenamiento secundario | Lenta | Grande | No volátil |

Esta estructura jerárquica, aunque evolutiva respecto al diseño original, mantiene el principio fundamental de la Arquitectura de Von Neumann: un espacio de memoria único donde instrucciones y datos coexisten, permitiendo la extraordinaria flexibilidad que caracteriza a los ordenadores modernos.

Cuello de botella de Von Neumann

A pesar de su elegancia y eficacia, la Arquitectura de Von Neumann presenta una limitación inherente conocida como el «cuello de botella de Von Neumann». Este fenómeno, identificado décadas después de la propuesta original, representa uno de los mayores desafíos en el diseño de computadoras modernas.

¿En qué consiste este cuello de botella?

El problema fundamental radica en que datos e instrucciones deben compartir el mismo canal de comunicación entre la CPU y la memoria. Esto crea una situación donde:

- La CPU debe alternar constantemente entre buscar instrucciones y buscar/almacenar datos.

- Solo una operación de memoria puede realizarse en cada ciclo.

- La velocidad de transferencia entre CPU y memoria limita el rendimiento global del sistema.

Con el avance tecnológico, las CPU han aumentado su velocidad de procesamiento mucho más rápidamente que la velocidad de acceso a memoria, agravando este cuello de botella. ¿Cómo afecta esto al rendimiento? En sistemas modernos, la CPU puede pasar hasta el 80% de su tiempo esperando datos de la memoria, un fenómeno conocido como «hambre de datos» (data starvation).

Estrategias para mitigar el cuello de botella

Los diseñadores de hardware han implementado diversas técnicas para aliviar este problema inherente a la Arquitectura de Von Neumann:

- Memoria caché: Múltiples niveles de memoria ultrarrápida cercana a la CPU que almacenan temporalmente instrucciones y datos frecuentemente utilizados.

- Prefetching: Anticipación y carga previa de instrucciones que probablemente se necesitarán pronto.

- Pipelines de instrucciones: Superposición de las fases de diferentes instrucciones para aprovechar los tiempos muertos.

- Procesamiento superescalar: Capacidad para ejecutar múltiples instrucciones simultáneamente.

- Procesadores multinúcleo: Distribución del trabajo entre varios núcleos de procesamiento.

Estas soluciones, aunque efectivas, representan adaptaciones y extensiones de la arquitectura original, sin abandonar su principio fundamental de memoria unificada. El cuello de botella de Von Neumann permanece como un recordatorio de que incluso los diseños más brillantes tienen limitaciones inherentes que deben abordarse con innovación continua.

Arquitectura Harvard: la alternativa a Von Neumann

Para comprender plenamente las implicaciones de la Arquitectura de Von Neumann, resulta esclarecedor contrastarla con su principal alternativa: la Arquitectura Harvard. Desarrollada también en la década de 1940 en la Universidad de Harvard (de ahí su nombre), ofrece un enfoque fundamentalmente diferente para la organización de un sistema computacional.

Diferencias fundamentales

La distinción esencial entre ambas arquitecturas radica en cómo manejan la memoria:

| Característica | Arquitectura de Von Neumann | Arquitectura Harvard |

|---|---|---|

| Espacios de memoria | Único espacio compartido para datos e instrucciones | Espacios físicamente separados para datos e instrucciones |

| Buses | Un único conjunto de buses para todas las transferencias | Buses separados para datos e instrucciones |

| Acceso simultáneo | No es posible acceder a datos e instrucciones simultáneamente | Permite acceso paralelo a datos e instrucciones |

| Cuello de botella | Sufre del cuello de botella Von Neumann | Evita este cuello de botella específico |

| Flexibilidad | Alta: los programas pueden modificarse a sí mismos | Menor: separación estricta entre código y datos |

| Seguridad | Potencialmente vulnerable a ataques que confunden datos e instrucciones | Mayor seguridad inherente contra ciertos tipos de ataques |

Aplicaciones modernas

Mientras que la mayoría de los ordenadores de propósito general emplean la Arquitectura de Von Neumann, la Arquitectura Harvard encuentra aplicaciones específicas en:

- Microcontroladores: Sistemas embebidos como Arduino utilizan esta arquitectura para operaciones deterministas y en tiempo real.

- DSPs (Procesadores de Señal Digital): Aprovechan el acceso paralelo para procesamiento eficiente de audio, video y otras señales.

- Sistemas de alto rendimiento: Algunos superordenadores implementan variantes de la Arquitectura Harvard para maximizar el ancho de banda de memoria.

Arquitecturas híbridas

En la práctica, muchos sistemas modernos implementan arquitecturas híbridas que combinan elementos de ambos modelos:

- Procesadores con cachés separadas para instrucciones y datos (L1i y L1d), pero unificadas en niveles superiores.

- GPUs con múltiples canales de memoria especializados para diferentes tipos de datos.

- Sistemas RISC avanzados que emplean buses dedicados para diferentes funciones.

Esta comparativa subraya uno de los aspectos más fascinantes de la Arquitectura de Von Neumann: su capacidad para evolucionar e integrar conceptos de otros modelos, manteniendo sus principios fundamentales a lo largo de décadas de revoluciones tecnológicas.

Evolución y avances de la Arquitectura de Von Neumann

Aunque los principios fundamentales de la Arquitectura de Von Neumann permanecen vigentes, el diseño ha experimentado transformaciones profundas para adaptarse a las crecientes demandas computacionales. Esta evolución representa un fascinante equilibrio entre fidelidad a los conceptos originales e innovación pragmática.

Extensiones arquitectónicas significativas

A lo largo de décadas, la arquitectura original ha incorporado numerosas mejoras:

- Registros especializados: Además de los registros generales, los procesadores modernos incluyen registros dedicados para operaciones de punto flotante, multimedia y virtualización.

- Predicción de saltos: Mecanismos sofisticados que anticipan el resultado de instrucciones condicionales, permitiendo la ejecución especulativa para mantener llenos los pipelines de instrucciones.

- Ejecución fuera de orden: Capacidad para reordenar instrucciones dinámicamente, maximizando el uso de unidades funcionales y minimizando tiempos de espera.

- Paralelismo a nivel de instrucción (ILP): Técnicas como la emisión múltiple, la ejecución superescalar y el procesamiento VLIW que permiten ejecutar varias instrucciones simultáneamente.

- Jerarquía de memoria extendida: Implementación de múltiples niveles de caché, memoria virtual, y tecnologías como NUMA (Non-Uniform Memory Access) que optimizan el acceso a memoria en sistemas multinúcleo.

Evolución hacia el paralelismo

Quizás el mayor desafío para la Arquitectura de Von Neumann tradicional ha sido la transición hacia el procesamiento paralelo:

- Arquitecturas multinúcleo: Integración de múltiples procesadores en un solo chip, cada uno manteniendo los principios Von Neumann pero ejecutando tareas en paralelo.

- Procesamiento vectorial: Extensiones como SSE, AVX y NEON que permiten aplicar una misma operación a múltiples datos simultáneamente (SIMD).

- Computación heterogénea: Integración de CPUs tradicionales con aceleradores especializados como GPUs, TPUs y NPUs, cada uno optimizado para diferentes cargas de trabajo.

¿Estos avances han transformado fundamentalmente la Arquitectura de Von Neumann? En cierto modo sí, pero es notable cómo el núcleo conceptual —programas almacenados en la misma memoria que los datos— ha demostrado una extraordinaria adaptabilidad. Incluso los sistemas más avanzados de hoy mantienen esta característica esencial, testimonio del genio visionario de von Neumann y sus contemporáneos.

Impacto en la computación moderna

La influencia de la Arquitectura de Von Neumann en el desarrollo tecnológico trasciende los aspectos puramente técnicos, habiendo moldeado profundamente cómo conceptualizamos, diseñamos y utilizamos los sistemas computacionales en prácticamente todos los ámbitos de la sociedad moderna.

Legado perdurable

El impacto de esta arquitectura se manifiesta en múltiples dimensiones:

- Universalidad computacional: La capacidad de ejecutar cualquier algoritmo computacionalmente posible mediante una secuencia de instrucciones simples almacenadas en memoria.

- Estandarización de diseño: Establecimiento de un paradigma dominante que permitió la evolución ordenada de generaciones de computadoras, desde mainframes hasta smartphones.

- Desarrollo de lenguajes de programación: La estructura de memoria unificada facilitó la creación de lenguajes cada vez más abstractos, desde el ensamblador hasta lenguajes de alto nivel como Python o Rust.

- Modelos educativos: La enseñanza de la informática a nivel mundial se fundamenta en los conceptos de la Arquitectura de Von Neumann, proporcionando un marco conceptual común para generaciones de profesionales.

Relevancia actual

A pesar de tener más de 75 años, esta arquitectura sigue siendo fundamental en la tecnología contemporánea:

- Los dispositivos móviles que llevamos en nuestros bolsillos siguen los principios básicos de von Neumann, aunque con extensiones significativas.

- Los centros de datos que sustentan la computación en la nube implementan variaciones altamente optimizadas de esta arquitectura.

- Incluso tecnologías emergentes como la computación cuántica utilizan conceptos derivados de von Neumann para sus sistemas de control clásicos.

¿Existe algún otro concepto en la historia de la informática que haya demostrado semejante longevidad y adaptabilidad? Pocos paradigmas tecnológicos han resistido tantas revoluciones manteniendo su relevancia esencial. La Arquitectura de Von Neumann no solo sobrevive como reliquia histórica, sino que continúa evolucionando activamente, demostrando una extraordinaria capacidad para incorporar innovaciones sin perder su esencia conceptual.

El futuro de la Arquitectura de Von Neumann

A medida que nos adentramos más profundamente en el siglo XXI, la Arquitectura de Von Neumann enfrenta desafíos sin precedentes. El fin de la Ley de Moore, los límites físicos de la miniaturización y las crecientes demandas computacionales de campos como la inteligencia artificial plantean interrogantes fundamentales sobre la viabilidad a largo plazo de este paradigma. ¿Está llegando esta arquitectura al final de su extraordinaria trayectoria, o simplemente está preparándose para otra reinvención?

Tendencias emergentes

Varias direcciones de investigación y desarrollo sugieren posibles evoluciones:

- Computación neuromórfica: Sistemas inspirados en la estructura del cerebro humano que abandonan parcialmente el modelo Von Neumann en favor de arquitecturas donde el procesamiento y la memoria están entrelazados, similar a las redes neuronales biológicas.

- Memorias computacionales: Tecnologías como la «computación en memoria» (in-memory computing) que realizan operaciones lógicas directamente en los dispositivos de almacenamiento, difuminando la separación tradicional entre CPU y memoria.

- Arquitecturas asíncronas: Sistemas que abandonan el reloj central sincronizado en favor de componentes que operan a su propio ritmo, comunicándose mediante protocolos de handshaking.

- Computación reversible y adiabática: Diseños que intentan superar los límites termodinámicos de la computación convencional, potencialmente permitiendo eficiencias energéticas radicalmente mejoradas.

- Arquitecturas aproximadas: Sistemas que sacrifican precisión por eficiencia en aplicaciones tolerantes a errores, como análisis de datos masivos y procesamiento sensorial.

Coexistencia con paradigmas alternativos

Es probable que el futuro cercano no presencie un reemplazo abrupto de la Arquitectura de Von Neumann, sino una creciente especialización y diferenciación:

- Sistemas de propósito general que mantienen y refinan el modelo Von Neumann para aplicaciones donde su flexibilidad sigue siendo invaluable.

- Aceleradores especializados con arquitecturas radicalmente diferentes optimizadas para dominios específicos como procesamiento de señales, redes neuronales o simulaciones físicas.

- Sistemas híbridos que integran múltiples paradigmas arquitectónicos bajo una capa de abstracción unificada, seleccionando dinámicamente la arquitectura óptima para cada tarea.

El genio de la Arquitectura de Von Neumann no radica solo en su diseño original, sino en su extraordinaria capacidad para evolucionar. Esta adaptabilidad sugiere que, aunque su forma pueda transformarse radicalmente, los principios conceptuales fundamentales continuarán influyendo en el diseño computacional durante décadas venideras.

Conclusiones

La Arquitectura de Von Neumann representa mucho más que un simple diseño técnico; constituye uno de los pilares fundamentales sobre los que se ha construido nuestra civilización digital. Su influencia trasciende el ámbito de la ingeniería informática para impactar profundamente en nuestra sociedad, economía y cultura.

A lo largo de este análisis, hemos explorado cómo este paradigma revolucionario estableció los cimientos conceptuales para la computación moderna, desde sus orígenes históricos hasta sus desafíos futuros. Hemos visto cómo sus componentes fundamentales —CPU, memoria unificada, buses y dispositivos de entrada/salida— cooperan armoniosamente para ejecutar programas almacenados con extraordinaria flexibilidad.

También hemos analizado sus limitaciones inherentes, particularmente el famoso «cuello de botella», y las ingeniosas estrategias desarrolladas para superarlas. La comparación con arquitecturas alternativas como la Harvard nos ha permitido apreciar tanto las fortalezas como las debilidades del enfoque de Von Neumann.

¿Qué nos depara el futuro? La Arquitectura de Von Neumann se encuentra en una encrucijada fascinante, donde los límites físicos desafían el modelo tradicional mientras emergen paradigmas alternativos. Sin embargo, su extraordinaria adaptabilidad sugiere que, lejos de desaparecer, continuará evolucionando e integrando nuevos conceptos sin perder su esencia.

El legado de John von Neumann y sus contemporáneos permanece vibrante y relevante. Cada vez que utilizamos una computadora —desde el más modesto microcontrolador hasta el más avanzado superordenador— estamos aprovechando su visión revolucionaria. La Arquitectura de Von Neumann no es simplemente historia de la informática; es una fuerza viva que continúa moldeando nuestro presente tecnológico y preparando el camino hacia futuros aún inimaginables.

Referencias externas

- Arquitectura de Von Neumann – Wikipedia

- Departamento de Informática, Universidad de Valencia. «Fundamentos de Arquitectura de Computadores».

- Institute of Electrical and Electronics Engineers (IEEE). «Computer Architecture: A Quantitative Approach».

- Tanenbaum, A. S. (2016). «Structured Computer Organization».